Machine Learning : L'apprentissage par renforcement

Comparaison

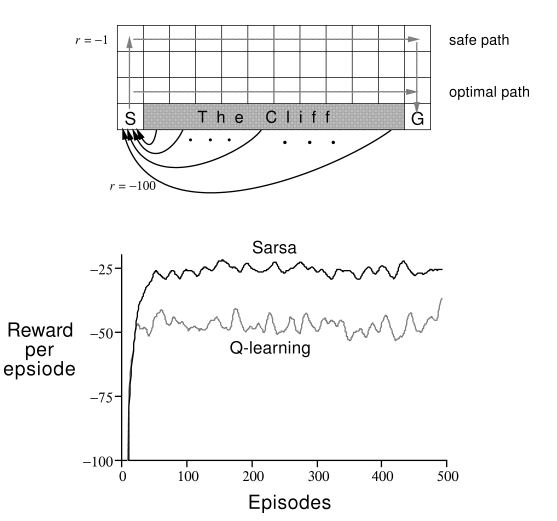

Q-Learning Vs Sarsa

On ne peut pas dire que l’un des algorithmes est mieux que l’autre :

- L’avantage de Sarsa est qu'il prend en compte la politique réelle du système, plutôt que de supposer simplement qu’il fait le bon choix.

- L’avantage de Q-Learning est qu'il prend en compte que votre politique change régulièrement, il pourrait être beaucoup plus souhaitable d'utiliser l'approche Q-learning et apprendre en supposant que vous êtes en mouvement de manière optimale.

On notera que Q Learning et SARSA se ressemblent beaucoup. Dans le cas de SARSA, la méthode est exactement on-line: la formule de mise à jour suit exactement le choix de l'action (qui n'est pas toujours optimale). Dans le cas de Q Learning, la méthode est presque on-line: la formule de mise à jour utilise la valeur optimale des actions possibles après l'état suivant, alors que comme dans SARSA, l'action choisie après l'état suivant peut ne pas être optimale. Cette petite différence entre SARSA et Q Learning rend Q learning un peu plus efficace, mais SARSA plus sûre.